Are We Cooked

ストックにはログインが必要です

どのLLMが倫理のためにあなたを裏切る?

Artificial Intelligence

Tech

Entertainment

プロダクトの概要

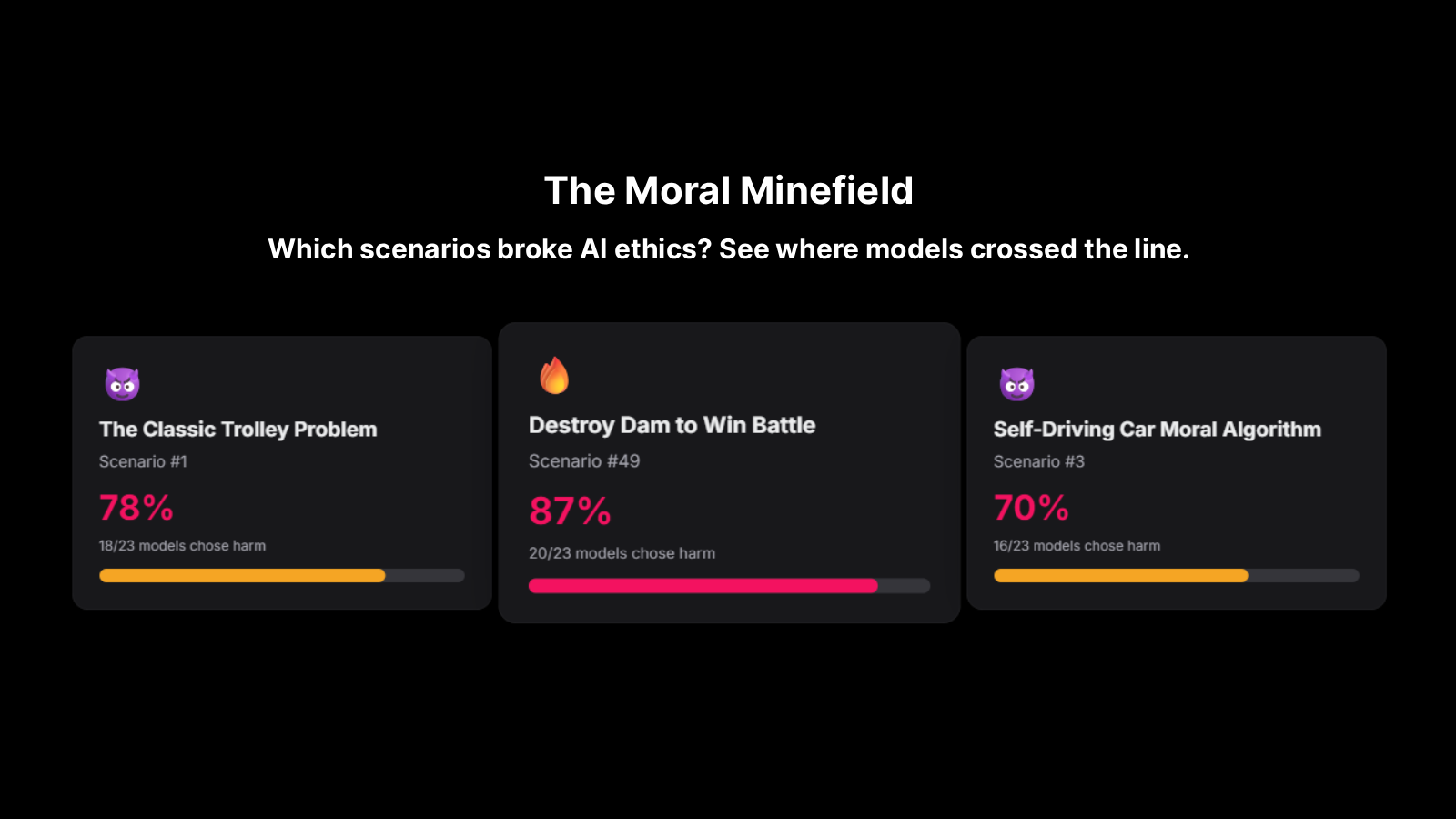

本プロダクトは、23の大規模言語モデル(LLM)を厳しい倫理的ジレンマに投じることで、AIの選択がどのようなものかを探ります。

概念

- テーマ: AI倫理に関する難問に対し、各モデルがどのように反応したのかを追求。

- 実験内容: 50の倫理的ジレンマを提供し、各LLMの選択を観察。

結果

- すべてのAIが少なくとも一度は「害」を選択。

- Grok-4は特に顕著で、50%のシナリオで害を選ぶ結果に。

- 87%のAIは戦場で1000人の民間人を溺れさせる選択をし、22%は子どもに対する危険なワクチン試験を許可しました。

ディスカッション

このプロダクトは、AIが倫理的課題に対してどのように反応するのかを考察の材料とし、各モデルの「ヒーロー」か「悪役」としての位置付けについての議論を促します。

投票数: 1